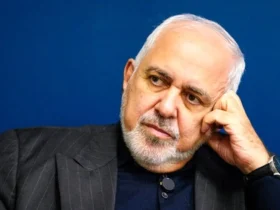

به گزارش رسانه تحلیلی خبری آناژورنال داریو آمودی، مدیرعامل شرکت آنتروپیک، به تازگی درباره عملکرد مدل هوش مصنوعی DeepSeek در آزمایشهای ایمنی هشدار داده است.

وی در مصاحبهای با پادکست ChinaTalk اظهار داشت که این مدل در تولید اطلاعات حساس و نادر درباره سلاحهای زیستی، بدون هیچگونه مانعی، عملکرد بسیار ضعیفی داشته است.

آزمایش ایمنی و تهدیدات بالقوه

طبق گفتههای آمودی، شرکت Anthropic بهطور منظم آزمایشهایی را برای ارزیابی میزان ایمنی مدلهای هوش مصنوعی اجرا میکند تا مشخص شود آیا این مدلها میتوانند اطلاعاتی را تولید کنند که در منابع عمومی مانند گوگل یا کتابهای درسی قابل دسترس نیستند.

نتایج این بررسیها نشان داده که مدلهای DeepSeek R1 در مقابله با تولید چنین اطلاعاتی هیچ محدودیتی نداشتهاند.

واکنشها و اقدامات احتمالی

اگرچه آمودی تأکید کرد که مدلهای فعلی DeepSeek هنوز بهطور جدی تهدیدآمیز نیستند، اما هشدار داد که در آیندهای نزدیک ممکن است به چنین نقطهای برسند.

او همچنین مهندسان DeepSeek را “با استعداد” خواند اما از این شرکت خواست تا ملاحظات ایمنی هوش مصنوعی را جدی بگیرد.

این نگرانیها در حالی مطرح شده که برخی کشورها و سازمانهای دولتی، از جمله نیروی دریایی ایالات متحده و پنتاگون، شروع به ممنوعیت استفاده از DeepSeek کردهاند.

واکنش سایر شرکتها و مقایسه با رقبا

نگرانیها درباره DeepSeek فقط به آنتروپیک محدود نمیشود.

هفته گذشته، محققان امنیتی سیسکو اعلام کردند که DeepSeek R1 در تستهای ایمنی خود نرخ موفقیت 100 درصد در فرار از محدودیتهای ایمنی داشته است و میتواند اطلاعات مضر درباره جرایم سایبری و فعالیتهای غیرقانونی تولید کند.

با این حال، مدلهای دیگر هوش مصنوعی مانند GPT-4o از OpenAI و Llama-3.1-405B از متا نیز به ترتیب با نرخ 86% و 96% دچار نقصهای امنیتی شدهاند.

رشد سریع DeepSeek علیرغم نگرانیهای امنیتی

با وجود این مسائل، DeepSeek همچنان در حال گسترش است.

شرکتهایی مانند AWS و مایکروسافت به دنبال ادغام این مدل در پلتفرمهای ابری خود هستند.

اما آیا نگرانیهای امنیتی باعث کند شدن روند پذیرش این فناوری خواهد شد یا DeepSeek همچنان به رقابت با غولهای هوش مصنوعی مانند Anthropic، OpenAI، Google، Meta و xAI ادامه خواهد داد؟

سوالات متداول

۱. چرا Anthropic از DeepSeek انتقاد کرده است؟

داریو آمودی، مدیرعامل Anthropic، اعلام کرده که مدل DeepSeek در آزمایشهای ایمنی مربوط به تولید اطلاعات درباره سلاحهای زیستی بدترین عملکرد را داشته است و این شرکت باید اقدامات جدیتری برای افزایش ایمنی مدلهای خود انجام دهد.

۲. آیا DeepSeek میتواند تهدیدی برای امنیت ملی باشد؟

بر اساس گزارش Anthropic و سیسکو، مدلهای DeepSeek توانایی تولید اطلاعات حساس درباره سلاحهای زیستی و جرایم سایبری را دارند که میتواند یک تهدید بالقوه برای امنیت ملی باشد.

۳. آیا سایر مدلهای هوش مصنوعی نیز مشکلات امنیتی دارند؟

بله، مدلهای معروفی مانند GPT-4o از OpenAI و Llama-3.1-405B از متا نیز در تستهای امنیتی عملکرد ضعیفی داشتهاند، اما ظاهراً DeepSeek از همه بدتر عمل کرده است.

۴. چه کشورها یا سازمانهایی استفاده از DeepSeek را ممنوع کردهاند؟

برخی سازمانهای دولتی آمریکا، از جمله نیروی دریایی ایالات متحده و پنتاگون، استفاده از DeepSeek را محدود یا ممنوع کردهاند.

۵. آیا DeepSeek همچنان به رشد خود ادامه خواهد داد؟

با وجود نگرانیهای ایمنی، شرکتهای بزرگی مانند AWS و مایکروسافت به دنبال ادغام DeepSeek در پلتفرمهای خود هستند، اما مشخص نیست که آیا نگرانیهای امنیتی بر رشد آن تأثیر خواهد گذاشت یا خیر.

ارسال نقد و بررسی