به گزارش رسانه تحلیلی خبری آناژورنال یک تیم تحقیقاتی متشکل از پژوهشگران دانشگاههای Wellesley College، Oberlin College، University of Texas at Austin، Northeastern University، Charles University و استارتاپ Cursor، با استفاده از معماهای NPR Sunday Puzzle یک معیار جدید برای ارزیابی توانایی استدلال مدلهای هوش مصنوعی توسعه دادند.

نتایج نشان داد که برخی از این مدلها هنگام مواجهه با چالشهای پیچیده “تسلیم” شده و پاسخهای تصادفی ارائه میدهند!

چرا معماهای NPR؟

معماهای NPR بهگونهای طراحی شدهاند که افراد بدون نیاز به دانش خاص، تنها با استدلال منطقی قادر به حل آنها باشند.

آرجون گوها (Arjun Guha)، استاد علوم کامپیوتر در دانشگاه Northeastern و یکی از نویسندگان این مطالعه، میگوید:

“ما به دنبال معیاری بودیم که نیاز به دانش تخصصی نداشته باشد و بیشتر بر قدرت استدلال مدلها تمرکز کند. معماهای NPR این ویژگی را دارند.”

نتایج حیرتانگیز؛ هوش مصنوعی تسلیم میشود!

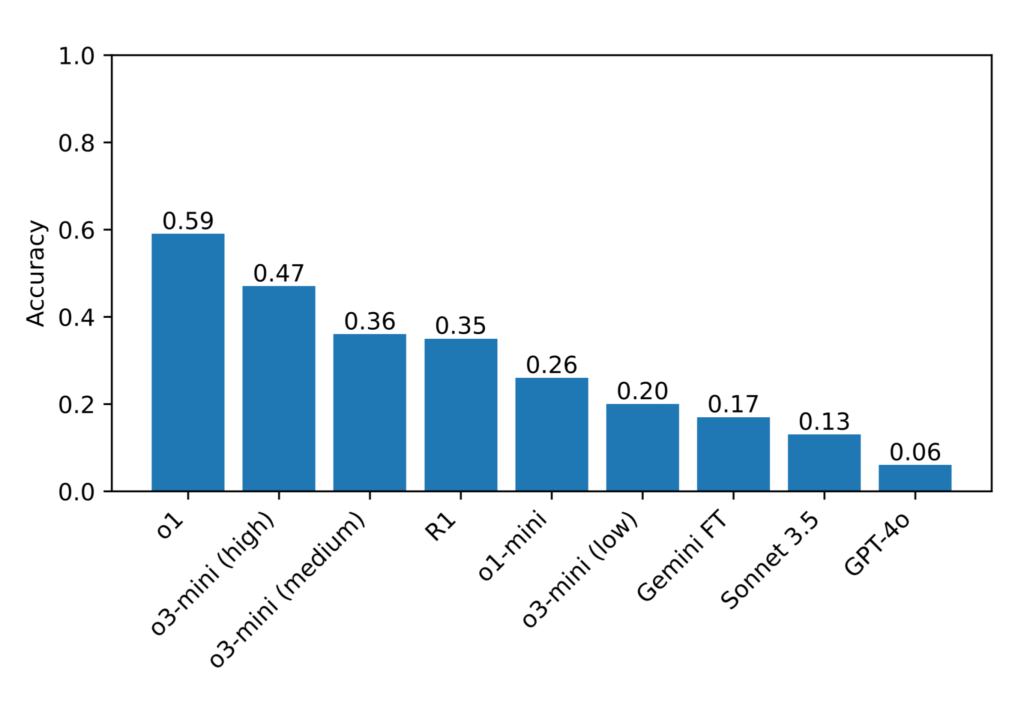

این تحقیق بر روی حدود 600 معمای NPR انجام شد و مدلهای o1، DeepSeek R1 و o3-mini مورد آزمایش قرار گرفتند.

مدل o1 با دقت 59٪ بهترین عملکرد را داشت، درحالیکه مدل R1 تنها 35٪ امتیاز کسب کرد.

اما نکته جالبتر این بود که مدل R1 گاهی اوقات مستقیماً اعلام میکرد که “تسلیم” شده است!

در برخی موارد، این مدل پس از چندین تلاش ناموفق، جملهای مانند “من تسلیم میشوم” تولید کرده و سپس پاسخی تصادفی ارائه میداد.

این رفتار به طرز شگفتآوری شبیه به واکنش انسانها در مواجهه با چالشهای سخت است.

برخی از مشکلات رایج در عملکرد مدلها:

🔹 ارائه پاسخ اشتباه و سپس تلاش برای تصحیح آن، اما دوباره شکست خوردن

🔹 گیر کردن در یک چرخه بیپایان پردازش و ناتوانی در ارائه پاسخ نهایی

🔹 دادن پاسخ درست، اما سپس ادامه دادن به تحلیلهای بیدلیل و ارائه پاسخهای جایگزین

تأثیر این تحقیق بر آینده هوش مصنوعی

گوها در ادامه میافزاید:

“ما در حال ورود به عصری هستیم که مدلهای هوش مصنوعی در حوزههای گوناگون مورد استفاده قرار میگیرند. اما این نتایج نشان میدهد که هنوز محدودیتهای جدی در توانایی استدلال این مدلها وجود دارد.”

این تیم تحقیقاتی قصد دارد آزمایشهای بیشتری را با مدلهای جدیدتر انجام دهد تا نقاط ضعف و قوت هوش مصنوعی در پردازش منطق و حل مسائل پیچیده را بهتر درک کند.

آیا هوش مصنوعی واقعاً میتواند مانند انسان فکر کند؟

با وجود پیشرفتهای گسترده، نتایج این تحقیق نشان میدهد که مدلهای هوش مصنوعی هنوز در درک و حل برخی چالشهای منطقی دچار ضعف هستند.

این موضوع سؤالات مهمی را درباره آیندهی هوش مصنوعی و قابلیتهای آن برای انجام وظایف پیچیدهتر مطرح میکند.

نظر شما چیست؟ آیا روزی میرسد که هوش مصنوعی واقعاً بتواند مانند انسان فکر کند؟

سوالات متداول (FAQ):

1. چرا از معماهای NPR برای ارزیابی هوش مصنوعی استفاده شده است؟

معماهای NPR نیاز به دانش عمومی و استدلال منطقی دارند، بنابراین مدلهای هوش مصنوعی نمیتوانند فقط بر اساس حافظه پاسخ دهند و باید واقعاً “فکر” کنند.

2. کدام مدل هوش مصنوعی بهترین عملکرد را در این آزمون داشت؟

مدل o1 با امتیاز 59٪ بهترین عملکرد را داشت، در حالی که مدل R1 تنها 35٪ امتیاز کسب کرد.

3. آیا این آزمایش محدودیتهایی دارد؟

بله، این معماها فقط به زبان انگلیسی هستند و برخی از مدلها ممکن است قبلاً با آنها آموزش دیده باشند، که میتواند نتایج را تحت تأثیر قرار دهد.

4. چرا برخی از مدلهای هوش مصنوعی “تسلیم” شده و پاسخهای اشتباه میدهند؟

برخی مدلها وقتی نمیتوانند راهحلی پیدا کنند، پاسخی تصادفی ارائه داده یا حتی اعلام میکنند که “تسلیم” شدهاند، رفتاری که شبیه انسانهای واقعی در مواجهه با چالشهای دشوار است.

ارسال نقد و بررسی